Xorbits Inference(Xinference)是一个性能强大且功能全面的分布式推理框架。可用于大语言模型(LLM),语音识别模型,多模态模型等各种模型的推理。通过 Xorbits Inference,你可以轻松地一键部署你自己的模型或内置的前沿开源模型。无论你是研究者,开发者,或是数据科学家,都可以通过 Xorbits Inference 与最前沿的 AI 模型,发掘更多可能。

- 支持 Transformers 引擎的持续批处理: #1724

- 支持针对苹果芯片优化的MLX后端: #1765

- 支持加载模型时指定 worker 和 GPU 索引: #1195

- 支持 SGLang 后端: #1161

- 支持LLM和图像模型的LoRA: #1080

- 支持语音识别模型: #929

- 增加 Metrics 统计信息: #906

- 内置 CogVideoX: #2049

- 内置 flux.1-schnell & flux.1-dev: #2007

- 内置 MiniCPM-V 2.6: #2031

- 内置 Kolors: #2028

- 内置 SenseVoice: #2008

- 内置 Mistral Large 2: #1944

- 内置 llama3.1: #1932

- 内置 Mistral Nemo: #1936

- FastGPT:一个基于 LLM 大模型的开源 AI 知识库构建平台。提供了开箱即用的数据处理、模型调用、RAG 检索、可视化 AI 工作流编排等能力,帮助您轻松实现复杂的问答场景。

- Dify: 一个涵盖了大型语言模型开发、部署、维护和优化的 LLMOps 平台。

- Chatbox: 一个支持前沿大语言模型的桌面客户端,支持 Windows,Mac,以及 Linux。

- RAGFlow: 是一款基于深度文档理解构建的开源 RAG 引擎。

🌟 模型推理,轻而易举:大语言模型,语音识别模型,多模态模型的部署流程被大大简化。一个命令即可完成模型的部署工作。

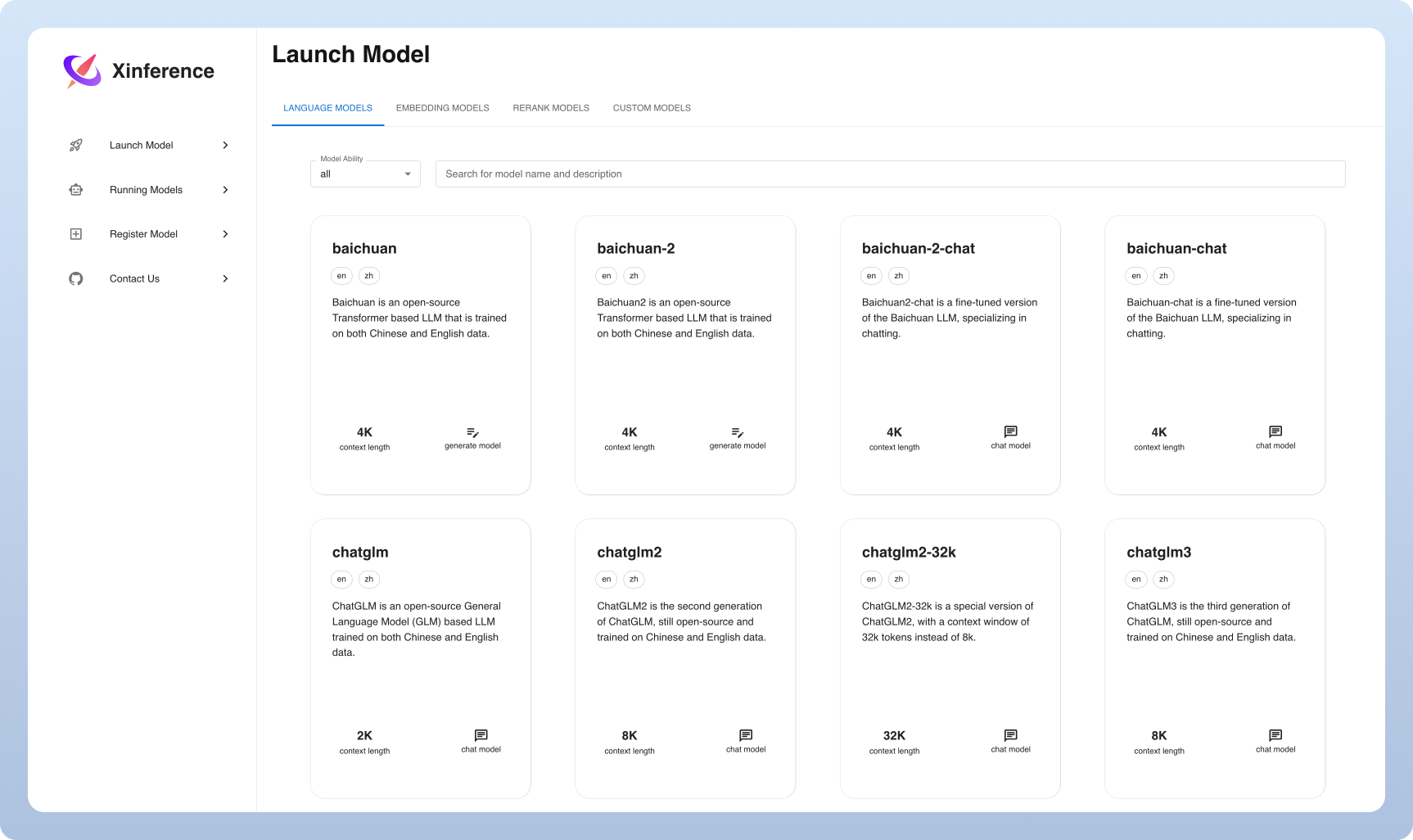

⚡️ 前沿模型,应有尽有:框架内置众多中英文的前沿大语言模型,包括 baichuan,chatglm2 等,一键即可体验!内置模型列表还在快速更新中!

🖥 异构硬件,快如闪电:通过 ggml,同时使用你的 GPU 与 CPU 进行推理,降低延迟,提高吞吐!

⚙️ 接口调用,灵活多样:提供多种使用模型的接口,包括 OpenAI 兼容的 RESTful API(包括 Function Calling),RPC,命令行,web UI 等等。方便模型的管理与交互。

🌐 集群计算,分布协同: 支持分布式部署,通过内置的资源调度器,让不同大小的模型按需调度到不同机器,充分使用集群资源。

🔌 开放生态,无缝对接: 与流行的三方库无缝对接,包括 LangChain,LlamaIndex,Dify,以及 Chatbox。

| 功能特点 | Xinference | FastChat | OpenLLM | RayLLM |

|---|---|---|---|---|

| 兼容 OpenAI 的 RESTful API | ✅ | ✅ | ✅ | ✅ |

| vLLM 集成 | ✅ | ✅ | ✅ | ✅ |

| 更多推理引擎(GGML、TensorRT) | ✅ | ❌ | ✅ | ✅ |

| 更多平台支持(CPU、Metal) | ✅ | ✅ | ❌ | ❌ |

| 分布式集群部署 | ✅ | ❌ | ❌ | ✅ |

| 图像模型(文生图) | ✅ | ✅ | ❌ | ❌ |

| 文本嵌入模型 | ✅ | ❌ | ❌ | ❌ |

| 多模态模型 | ✅ | ❌ | ❌ | ❌ |

| 语音识别模型 | ✅ | ❌ | ❌ | ❌ |

| 更多 OpenAI 功能 (函数调用) | ✅ | ❌ | ❌ | ❌ |

在开始之前,请给我们一个星标,这样你就可以在 GitHub 上及时收到每个新版本的通知!

体验 Xinference 最轻量级的方式是使用我们 Google Colab 上的 Jupyter Notebook。

Nvidia GPU 用户可以使用Xinference Docker 镜像 启动 Xinference 服务器。在执行安装命令之前,确保你的系统中已经安装了 Docker 和 CUDA。

确保你的 Kubernetes 集群开启了 GPU 支持,然后通过 helm 进行如下方式的安装。

# 新增xinference仓库

helm repo add xinference https://xorbitsai.github.io/xinference-helm-charts

# 更新仓库,查询可安装的版本

helm repo update xinference

helm search repo xinference/xinference --devel --versions

# 在K8s中安装xinference

helm install xinference xinference/xinference -n xinference --version 0.0.1-v<xinference_release_version>

更多定制化安装方式,请参考文档。

使用 pip 安装 Xinference,操作如下。(更多选项,请参阅安装页面。)

pip install "xinference[all]"要启动一个本地的 Xinference 实例,请运行以下命令:

$ xinference-local一旦 Xinference 运行起来,你可以通过多种方式尝试它:通过网络界面、通过 cURL、通过命令行或通过 Xinference 的 Python 客户端。更多指南,请查看我们的文档。

| 平台 | 目的 |

|---|---|

| Github 问题 | 报告错误和提交功能请求。 |

| Slack | 与其他 Xorbits 用户合作。 |

| 及时了解新功能。 | |

| 微信社群 | 与其他 Xorbits 用户交流。 |

| 知乎 | 了解团队最新的进展。 |