Wenn Sie eine generative KI-Anwendung entwickeln möchten, können Sie GitHub Models verwenden, um KI-Modelle kostenlos zu suchen und mit ihnen zu experimentieren. Sobald Sie bereit sind, Ihre Anwendung in die Produktion zu bringen, können Sie von einem kostenpflichtigen Azure-Konto zu einem Token wechseln. Weitere Informationen finden Sie in der Azure KI-Dokumentation.

Weitere Informationen findest du auch unter Verantwortungsvolle Nutzung von GitHub-Modellen.

Finden von KI-Modellen

So suchst du ein KI-Modell:

-

Wechsle zu github.com/marketplace/models.

-

Klicke auf Model: Select a Model.

-

Wähle ein Modell aus dem Dropdownmenü aus.

Klicke alternativ im Dropdownmenü auf View all models, klicke auf ein Modell im Marketplace, und klicke dann auf Playground.

Das Modell wird im Modellplayground geöffnet. Details des Modells werden in der Randleiste auf der rechten Seite angezeigt. Wenn die Randleiste nicht angezeigt wird, erweitere sie, indem du auf das Symbol rechts neben dem Playground klickst.

Note

Der Zugang zu den Modellen von OpenAI befindet sich in public preview und kann sich noch ändern.

Experimentieren mit KI-Modellen im Playground

Der KI-Modell-Playground ist eine kostenlose Ressource, mit der du Modellparameter anpassen und Prompts übermitteln kannst, um zu sehen, wie ein Modell reagiert.

Note

- Der Modellplayground befindet in der public preview und kann sich noch ändern.

- Der Playground hat eine Ratenbegrenzung. Weitere Informationen finden Sie unter Ratenbegrenzung weiter unten.

Um Parameter für das Modell anzupassen, wähle im Playground die Registerkarte Parameters in der Randleiste aus.

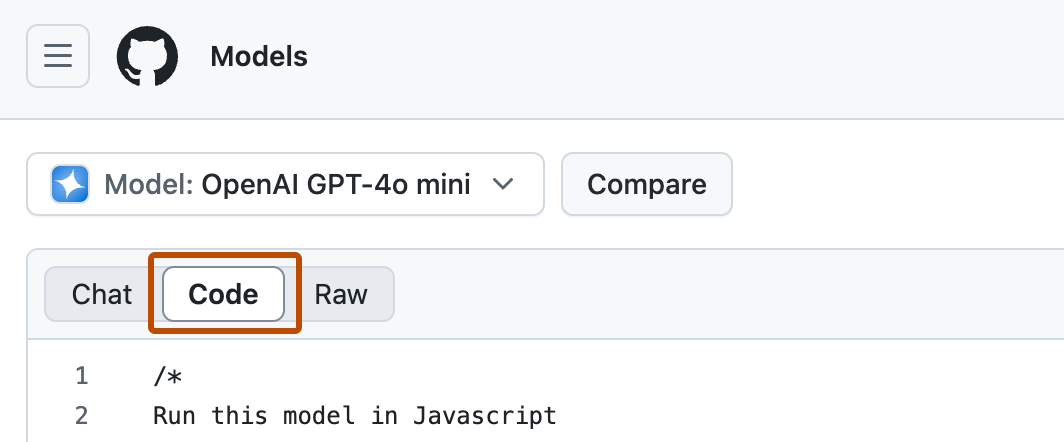

Um Code anzuzeigen, der den von Ihnen ausgewählten Parametern entspricht, wechseln Sie von der Registerkarte Chat zur Registerkarte Code.

Vergleich von Modellen

Du kannst einen Prompt gleichzeitig an zwei Modelle senden und die Antworten vergleichen.

Wenn ein Modell im Playground geöffnet ist, klicke auf Compare, und wähle dann im Dropdownmenü ein Modell für den Vergleich aus. Das ausgewählte Modell wird in einem zweiten Chatfenster geöffnet. Wenn du einen Prompt in einem Chatfenster eingibst, wird der Prompt im anderen Fenster gespiegelt. Die Prompts werden gleichzeitig übermittelt, damit du die Antworten aus jedem Modell vergleichen kannst.

Alle Parameter, die du festlegst, werden für beide Modelle verwendet.

Experimentieren mit KI-Modellen mithilfe der API

Note

Die kostenlose API-Nutzung ist in public preview und kann sich noch ändern.

GitHub bietet kostenlose API-Nutzung, sodass Sie mit KI-Modellen in Ihrer eigenen Anwendung experimentieren können.

Die Schritte zur Verwendung der einzelnen Modelle sind ähnlich. Sie müssen im Allgemeinen die folgenden Schritte ausführen:

-

Wechsle zu github.com/marketplace/models.

-

Klicke auf Model: Select a Model.

-

Wähle ein Modell aus dem Dropdownmenü aus.

Klicke alternativ im Dropdownmenü auf View all models, klicke auf ein Modell im Marketplace, und klicke dann auf Playground.

Das Modell wird im Modell-Playground geöffnet.

-

Klicke auf die Registerkarte Code.

-

Verwenden Sie optional das Sprach-Dropdown, um die Programmiersprache auszuwählen.

-

Optional können Sie das SDK-Dropdown verwenden, um auszuwählen, welches SDK verwendet werden soll.

Alle Modelle können mit dem Azure AI Inference SDK verwendet werden, und einige Modelle unterstützen zusätzliche SDKs. Wenn Sie einfach zwischen Modellen wechseln möchten, müssen Sie „Azure AI Inference SDK“ auswählen. Wenn Sie „REST“ als Sprache ausgewählt haben, verwenden Sie kein SDK. Stattdessen verwenden Sie den API-Endpunkt direkt.

-

Öffnen Sie entweder einen Codespace oder richten Sie Ihre lokale Umgebung ein:

- Um in einem Codespace auszuführen, klicken Sie auf Codespace ausführen und klicken Sie dann auf Neuen Codespace erstellen.

- Lokale Ausführung:

- Erstellen Sie ein GitHub personal access token. Das Token sollte keine Bereiche oder Berechtigungen besitzen. Weitere Informationen findest du unter Verwalten deiner persönlichen Zugriffstoken.

- Speichern Sie Ihr Token als Umgebungsvariable.

- Installieren Sie die Abhängigkeiten für das SDK, falls erforderlich.

-

Verwenden Sie den Beispielcode, um eine Anforderung an das Modell zu stellen.

Die kostenlose API-Nutzung ist eingeschränkt. Weitere Informationen finden Sie unter Ratenbegrenzung weiter unten.

Speichern und Freigeben deiner Playgroundexperimente

Du kannst den Status im Playground mit Voreinstellungen speichern und freigeben. Mit Voreinstellungen wird Folgendes gespeichert:

- Dein aktueller Status

- Deine Parameter

- Dein Chatverlauf (optional)

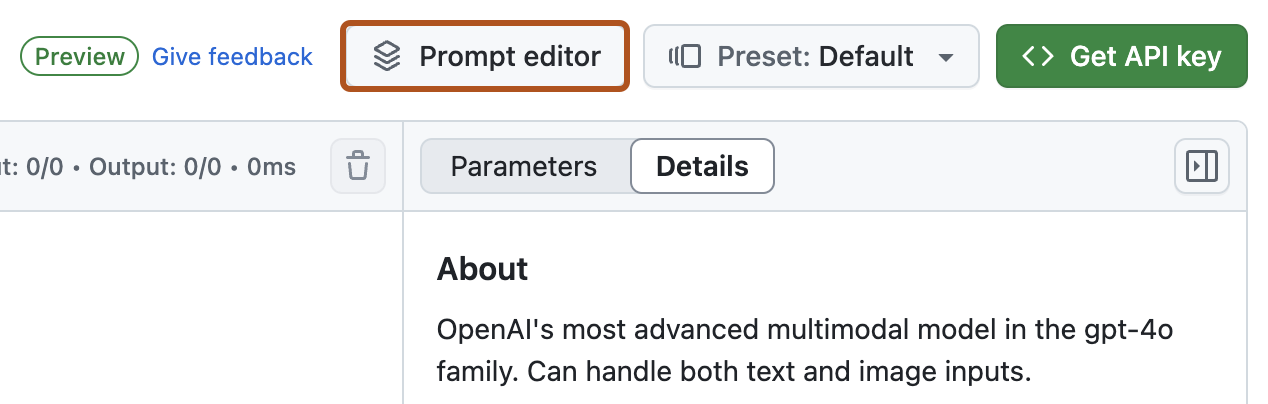

Um eine Voreinstellung für deinen aktuellen Kontext zu erstellen, wähle das Dropdownmenü Preset: PRESET-NAME oben rechts im Playground aus, und klicke dort auf Create new preset. Du musst deiner Voreinstellung einen Namen geben. Zudem kannst du für deine Voreinstellung eine Beschreibung eingeben, deinen Chatverlauf einbinden und zulassen, dass deine Voreinstellung freigegeben werden kann.

Es gibt zwei Möglichkeiten, eine Voreinstellung zu laden:

- Wähle im Dropdownmenü Preset: PRESET-NAME die Voreinstellung aus, die du laden möchtest.

- Öffnen der URL einer freigegebenen Voreinstellung

Nach dem Laden einer Voreinstellung kannst du diese bearbeiten, freigeben oder löschen.

- Um die Voreinstellung zu bearbeiten, änderst du die Parameter und rufst das Modell auf. Wenn du mit den Änderungen zufrieden bist, wählst du das Dropdownmenü Preset: PRESET-NAME aus und klickst dort auf Edit preset. Anschließend speicherst du deine Änderungen.

- Um die Voreinstellung freizugeben, wählst du das Dropdownmenü Preset: PRESET-NAME aus und klickst dort auf Share preset, um eine URL zu erhalten, die freigegeben werden kann.

- Um eine Voreinstellung zu löschen, wählst du das Dropdownmenü Preset: PRESET-NAME aus, klickst dort auf Delete preset und bestätigst den Löschvorgang.

Verwenden des Prompt-Editors

Der Prompt-Editor in GitHub Models soll dir helfen, Prompts zu durchlaufen, zu optimieren und zu perfektionieren. Diese dedizierte Ansicht bietet eine fokussierte und intuitive Oberfläche zum Erstellen und Testen von Eingaben, sodass du folgende Möglichkeiten hast:

- Schnelles Testen und Optimieren von Prompts ohne die Komplexität von mehrteiligen Interaktionen.

- Optimieren von Prompts, sodass sie präzise und relevant für deine Projekte sind.

- Verwenden eines speziellen Raums für einteilige Szenarios, um konsistente und optimierte Ergebnisse zu gewährleisten.

Klicke zum Aufrufen des Prompt-Editors oben rechts neben dem Playground auf Prompt editor.

Experimentieren mit KI-Modellen in Visual Studio Code

Note

Die KI-Toolkit-Erweiterung für Visual Studio Code befindet sich in public preview. Änderungen sind vorbehalten.

Wenn du mit KI-Modellen lieber in deiner IDE experimentierst, kannst du die KI-Toolkit-Erweiterung für Visual Studio Code installieren und dann Modelle mit einstellbaren Parametern und Kontexten testen.

-

Installiere die Vorabversion des KI-Toolkits für Visual Studio Code in Visual Studio Code.

-

Klicke zum Öffnen der Erweiterung auf das KI-Toolkit-Symbol in der Aktivitätsleiste.

-

Autorisiere das KI-Toolkit, eine Verbindung mit deinem GitHub-Konto herstellen zu dürfen.

-

Klicke im Panel „AI Toolkit“ im Abschnitt „My models“ auf Open Model Catalog, und suche nach einem Modell zum Experimentieren.

- Wenn du ein Modell auswählst, das über GitHub Models remote gehostet wird, klicke auf der Modellkarte auf Try in playground.

- Um ein Modell herunterzuladen und lokal zu verwenden, klicke auf der Modellkarte auf Download. Klicke nach dem Herunterladen auf derselben Modellkarte auf Load in playground.

-

Gibt in der Randleiste Kontextanweisungen und Rückschlussparameter für das Modell an und sende dann ein Prompt.

In die Produktion gehen

Die Ratenbeschränkungen für den Playground und die kostenlose API-Nutzung sollen Ihnen helfen, mit Modellen zu experimentieren und Ihre KI-Anwendung zu entwickeln. Sobald Sie bereit sind, Ihre Anwendung in die Produktion zu bringen, können Sie ein Token aus einem kostenpflichtigen Azure-Konto anstelle Ihres GitHub personal access token verwenden. Sie brauchen in Ihrem Code nichts weiter zu ändern.

Weitere Informationen finden Sie in der Azure KI-Dokumentation.

Ratenbegrenzungen

Die Playground- und die kostenlose API-Nutzung sind durch Anforderungen pro Minute, Anforderungen pro Tag, Token pro Anforderung und gleichzeitige Anforderungen eingeschränkt. Wenn Sie eine Ratenbegrenzung bekommen, müssen Sie warten, bis sich die erreichte Ratenbegrenzung zurückgesetzt habt, bevor Sie weitere Anforderungen vornehmen können.

Niedrige, hohe und Einbettungsmodelle weisen unterschiedliche Ratenbegrenzungen auf. Um zu sehen, welche Art von Modell Sie verwenden, verweisen Sie auf die Informationen des Modells in GitHub Marketplace.

| Ratenbegrenzungsebene | Ratenbegrenzungen | Copilot Free | Copilot Pro | Copilot Business | Copilot Enterprise |

|---|---|---|---|---|---|

| Niedrig | Anforderungen pro Minute | 15 | 15 | 15 | 20 |

| Anforderungen pro Tag | 150 | 150 | 300 | 450 | |

| Token pro Anforderung | 8000 Eingang, 4000 Ausgang | 8000 Eingang, 4000 Ausgang | 8000 Eingang, 4000 Ausgang | 8000 Eingang, 8000 Ausgang | |

| Gleichzeitige Anforderungen | 5 | 5 | 5 | 8 | |

| Hoch | Anforderungen pro Minute | 10 | 10 | 10 | 15 |

| Anforderungen pro Tag | 50 | 50 | 100 | 150 | |

| Token pro Anforderung | 8000 Eingang, 4000 Ausgang | 8000 Eingang, 4000 Ausgang | 8000 Eingang, 4000 Ausgang | 16000 Eingang, 8000 Ausgang | |

| Gleichzeitige Anforderungen | 2 | 2 | 2 | 4 | |

| Einbettung | Anforderungen pro Minute | 15 | 15 | 15 | 20 |

| Anforderungen pro Tag | 150 | 150 | 300 | 450 | |

| Token pro Anforderung | 64000 | 64000 | 64000 | 64000 | |

| Gleichzeitige Anforderungen | 5 | 5 | 5 | 8 | |

| Azure OpenAI o1-Vorschau | Anforderungen pro Minute | Nicht zutreffend | 1 | 2 | 2 |

| Anforderungen pro Tag | Nicht zutreffend | 8 | 10 | 12 | |

| Token pro Anforderung | Nicht zutreffend | 4000 Eingang, 4000 Ausgang | 4000 Eingang, 4000 Ausgang | 4000 Eingang, 8000 Ausgang | |

| Gleichzeitige Anforderungen | Nicht zutreffend | 1 | 1 | 1 | |

| Azure OpenAI o1-mini | Anforderungen pro Minute | Nicht zutreffend | 2 | 3 | 3 |

| Anforderungen pro Tag | Nicht zutreffend | 12 | 15 | 20 | |

| Token pro Anforderung | Nicht zutreffend | 4000 Eingang, 4000 Ausgang | 4000 Eingang, 4000 Ausgang | 4000 Eingang, 4000 Ausgang | |

| Gleichzeitige Anforderungen | Nicht zutreffend | 1 | 1 | 1 | |

| Azure OpenAI o3-mini | Anforderungen pro Minute | Nicht zutreffend | 2 | 3 | 3 |

| Anforderungen pro Tag | Nicht zutreffend | 12 | 15 | 20 | |

| Token pro Anforderung | Nicht zutreffend | 4000 Eingang, 4000 Ausgang | 4000 Eingang, 4000 Ausgang | 4000 Eingang, 4000 Ausgang | |

| Gleichzeitige Anforderungen | Nicht zutreffend | 1 | 1 | 1 | |

| DeepSeek-R1 | Anforderungen pro Minute | 1 | 1 | 2 | 2 |

| Anforderungen pro Tag | 8 | 8 | 10 | 12 | |

| Token pro Anforderung | 4000 Eingang, 4000 Ausgang | 4000 Eingang, 4000 Ausgang | 4000 Eingang, 4000 Ausgang | 4000 Eingang, 4000 Ausgang | |

| Gleichzeitige Anforderungen | 1 | 1 | 1 | 1 |

Diese Begrenzungen können ohne Vorherige Ankündigung geändert werden.

Hinterlassen von Feedback

Um Feedback zu GitHub Models zu hinterlassen, beginnen Sie eine neue Diskussion oder kommentieren Sie eine vorhandene Diskussion in der GitHub-Community.